Nel 1995, se avevi bisogno di mettere in rete dei computer, era molto probabile che finissi per acquistare, alla “modica” cifra di 150-200 mila Lire, una 3Com 509 EtherLink III. Era considerata la scheda di rete ISA a 10 Mbps più affidabile e performante dell’epoca, anche perché la 3Com vantava un pedigree di tutto rispetto: fu infatti fondata da Robert Metcalfe, uno degli inventori del protocollo Ethernet.

Pochi anni più tardi, Novell (leader del mercato delle reti aziendali con il suo sistema operativo NetWare) decise di dare una spintarella (disinteressata) al mercato delle schede di rete, introducendo due modelli a basso costo: la NE1000 (ISA, 10 Mbps) e la NE2000 (PCI, 10/100 Mbps). Ebbero anche un’idea tanto semplice quanto efficace: rilasciarne pubblicamente le specifiche per permettere a qualsiasi azienda di produrne dei cloni.

Tra questi, uno dei più diffusi fu la RTL8019AS, realizzata dalla taiwanese Realtek a partire dal 1996. Prodotto economico (costava circa 50-60 mila Lire) che manteneva lo standard ISA a 10 Mbps offrendo così una soluzione accessibile per espandere le reti locali.

Questa strategia contribuì enormemente alla diffusione delle LAN e di conseguenza di NetWare, almeno fino all’avvento di Windows NT4. Tuttavia, era opinione diffusa che questi cloni fossero di qualità inferiore rispetto alle più blasonate 3Com che pare avessero un controller integrato che svolgeva gran parte del lavoro di elaborazione, riducendo così il carico sulla CPU del computer e migliorando le prestazioni complessive. Si alimentò quindi un tediosissimo dibattito tra prestazioni e convenienza che giunse al termine soltanto verso il 2000, con l’uscita della Realtek 8139, la prima scheda di rete 100Mbit universalmente riconosciuta come economica e performante.

Ma quanto c’era di vero in quelle affermazioni e quanto invece era FUD? Un dato oggettivamente vero era che a differenza delle 3Com alcune NE1000 non erano Plug&Play e poteva occorrere un’utility DOS o lo spostamento manuale di alcuni jumpers per configurarne IO e IRQ

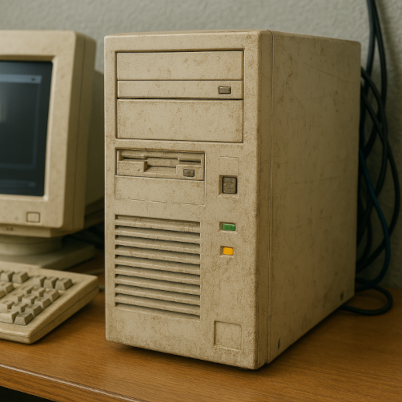

Per verificare il resto ho deciso di rispolverare un Pentium 133 di quell’epoca, equipaggiato con 64MB RAM, 128 di Swap e Debian Woody con kernel 2.4.18. Ci ho montato simultaneamente tutte e 4 schede di rete in questione ed ognuna è stata messa alla prova trasferendovi in upload (TX) ed in download (RX) per 10 volte un file da 100MB via ftp.

Per non aggiungere ulteriori variabili, il server ftp non si trovava sul P133. Ho anche effettuato anche svariate misurazioni in RX tramite http ed i valori ottenuti sono risultati perfettamente in linea con quelli registrati via ftp.

- 3Com EtherLink III 3C509 (ISA, 10 Mbps), modulo 3c509: RX 736 KB/s, TX 905 KB/s

- RTL8019AS (ISA, 10 Mbps), modulo ne: RX 703 KB/s, TX 940 KB/s

- RTL8029AS (PCI, 10 Mbps), modulo ne2k-pci: RX 735 KB/s, TX 989 KB/s

- RTL8139C (PCI, 100 Mbps), modulo 8139too: RX 2425 KB/s, TX 3028 KB/s

(Da notare come in tutti i casi la velocità in trasmissione sia risultata maggiore di quella in ricezione di quasi 1/3)

Attraverso il tool iperf ho misurato le velocità di trasmissione e ricezione sul protocollo UDP (così da bypassare eventuali latenze legate al TCP)

iperf -c 192.168.178.xxx -u -b 1000M -l 1470 -t 10 -i 1

- 3Com 509 ISA: RX 9.56 Mbits/sec, TX 9.89 Mbits/sec

- RTL8019AS ISA: RX 9.56 Mbits/sec, TX 9.44 Mbits/sec

- RTL8029AS PCI: RX 9.56 Mbits/sec, TX 9.51 Mbits/sec

- RTL8139C PCI: RX 62.2 Mbits/sec, TX 93.4 Mbits/sec

Al contrario di quanto veniva detto la scheda RTL8019AS, il clone NE su ISA, ha ottenuto velocità in trasmissione e ricezione paragonabili a quelle della famigerata 3Com ed al suo successore RTL8029AS su BUS PCI.

Chissà se effettuando i test su un 386 o 486 sarebbe potuto risultare più evidente il fantomatico maggiore carico sulla CPU di una NE compatibile rispetto alla 3Com. A quanto pare con Linux anche un P133 con 64MB di RAM era già in grado di compensare le presunte incolmabili inefficienze dell’economica RTL8019.